Publisert 4. desember 2014 kl. 10:33

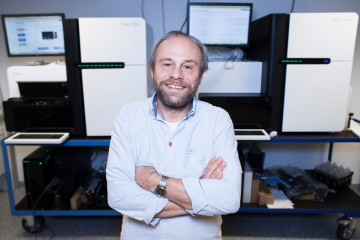

– Eg kallar dette eksplorativ forsking: Informasjonen kjem først, og hypotesane dukkar opp i etterkant, seier Kjetill S. Jakobsen. Foto: Erik Norrud

Superdatamaskina MareNostrum er del av eit europeisk tung-reknenettverk som Noreg er med i. Maskina står i ei gamal Kyrkje i Barcelona. Foto: Barcelona Supercompuiting Center.

– Skal vi verkeleg dra nytte av dei nasjonale biobankane og helseregistera, må det investerast meir i analysekompetanse, seier Inge Jonassen ved UiB.

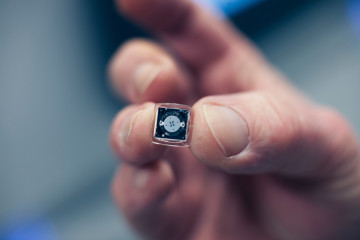

Her ligg biologisk materiale klart til sekvensering. Maskina har plass til mange slike brikker. Foto: Erik Norrud

Nei, sjå der. No har forskarane jammen funne genet for fedme, kan avisene fortelje. Eller var det alkoholisme, eller religiøsitet? Er det ikkje utruleg kva dei kan finne ut no om dagen, seier vi, og blar om.

Men slike spekulative overskrifter er kanskje mest av alt eit symptom på at noko har skjedd i biologien – og i vitskapen generelt. Gen er ikkje noko ein undersøker ved å trekke i feltbukse og liggje i lyngen og spionere på rype eller elg. Heller ikkje ved å sjå på celler under mikroskop. Hovudvekta i forskinga ligg ikkje berre på å frårøve naturen informasjon, éin observasjon om gongen. Etter kvart som maskiner gjer observasjonane for oss, er det blitt minst like utfordrande å forstå kva dei ufattelege informasjonsmengdene verda kastar etter oss, eigentleg fortel. Og ikkje minst korleis vi skal handtere dei.

Dataoverføring tek dagar

– For å gen-sekvensere biologisk materiale trengst det berre nokre milligram. Éi køyring i sekvenseringsmaskina tek nokre dagar, og ut kjem det typisk ein terabase med rådata, fortel Kjetill S. Jakobsen ved Senter for økologisk og evolusjonær syntese (CEES) ved Universitetet i Oslo (UiO).

Ein base er ein av dei fire byggesteinane i DNA-et: A, C, G eller T, som dei blir kalla mellom vener. Ein terabase er ein billion – ti i tolvte potens – basar.

– Sekvenseringsmaskina produserer eigentleg ei enorm mengd bildefiler over tid, som til saman utgjer ein film med veldig høg oppløysing, der DNA-et er lysglimt. I første omgang blir filmen overført til ein koloss av ei datamaskin som står 20 centimeter frå sekvenseringsmaskina, og berre den prosessen tek fleire dagar. Der blir filmen gjord om til eit format som kan lagrast på ei superdatamaskin. Etterpå blir filmen kasta. Vi skulle gjerne ha lagra filmen også, men han tek så stor plass at det er ikkje til å tenkje på eingong. Så om noko går gale, må vi gjere heile prosessen på nytt, seier Jakobsen.

Det fjerde paradigmet

Mange kjenner tommelfingerregelen om at reknekapasiteten i datamaskiner blir dobla på knappe to år. Problemet er berre at datamengdene som maskinene skal rekne på, blir dobla fleire gonger på den same tida, og kva gjer ein då? Så lenge gen-sekvensering var dyrt og vanskeleg, var det råd å halde datamengdene under kontroll. No har kostnadane sokke, og dei seier det berre er eit spørsmål om tid før gen-sekvensering blir ein rutinemessig del av ein vanleg legekonsultasjon. Datamengdene opnar nesten grenselause moglegheiter, men dei kan like gjerne bli ein propp i systemet.

[wip4: photo=723868 width=512 align=middle]

Datadriven forsking blir gjerne kalla det fjerde forskingsparadigmet, ifølgje spesialrådgjevar Roar Skålin i Forskingsrådet.

– Først gjekk naturvitskapleg forsking anten ut på å samle observasjonar som du tolka, eller å utvikle teoriar som du testa. Så kom eit tredje paradigme: simulering, slik vi kjenner det frå klimamodellane. Dei siste åra har forskingsinstrumenta produsert så mykje data at det å formulere forskingsresultat på bakgrunn av dei, i seg sjølv er blitt eit forskingsparadigme. Men for å få til det må ein også greie å handtere og merke datasetta på ein slik måte at dei kan gje meining.

Kan ikkje spare på alt

Som privatpersonar har vi fått merke dei gode sidene ved utviklinga. Vi fyller mobiltelefonane, datamaskinene og skytenestene med digitale bilete, og likevel blir det aldri fullt. Det er ikkje lenger nødvendig å kaste noko. Vi kan spare på alt. Så heldige er ikkje forskarane.

– Det kostar å lagre data, så ein må vere selektiv. Kjerneforskingseksperimenta ved CERN i Sveits produserer heilt ufattelege mengder data, men dei kastar nesten alt med ein gong. Dei har system som greier å filtrere ut dei hendingane som er interessante å sjå nærare på, ta vare på dei og kaste resten. Og likevel blir det så mykje data at dei må lagrast over heile Europa. Vi har ein del av dei i Noreg, seier Skålin.

Lenge var det dei store modelleringsfaga, som fysikk og klimaforsking, som hadde behov for tungreknemaskiner og lagringsplass. Men no kjem biovitskapane, helseforskinga, språk- og samfunnsvitskapane etter. Difor blir det brukt stadig større summar på såkalla e-infrastruktur – tungreknemaskiner, diskplass, overføringskapasitet, analyseprogram, databasar – både i Noreg og elles i verda. Då oktoberfristen for å søke pengar frå Forskingsrådet gjekk ut, var det kome inn 88 søknader til infrastrukturprogrammet. Handtering av store datamengder inngjekk i om lag 40 av dei. Totalt er det søkt om 4,3 milliardar kroner, og det er 600–800 millionar til fordeling i denne omgangen.

Betre føre var

Eit utval oppnemnt av Forskingsrådet har greidd ut om det vitskaplege behovet for e-infrastruktur i Noreg, og framhevar livsvitskapane som eitt av fleire fagområde der e-infrastruktur er særskilt viktig. Det same har EU konkludert med. Sidan 2002 har EU hatt eit eige såkalla strategiforum for felleseuropeisk forskingsinfrastruktur, ESFRI. Der ligg det til kvar tid fleire titals store og dyre infrastrukturprosjekt til mogning, men i mai i år vart det bestemt at tre prosjekt skal prioriterast akkurat no. Eitt av dei tre er ein europeisk infrastruktur for lagring og deling av data frå livsvitskapane: The European Life-Science Infrastructure for Biological Information, Elixir. Noreg vart medlem av Elixir i 2013.

– For femten år sidan kunne forskarane framleis ha datasetta på sin eigen laptop. Utfordringa låg i å analysere dei. No er mengdene så store at det er blitt ei utfordring å finne lagringsplass til dei. Og behovet for analysekompetanse er ikkje blitt mindre, seier professor i bioinformatikk ved Universitetet i Bergen (UiB), Inge Jonassen. Han leier den norske Elixir-noden, som byggjer på tolv års erfaring frå den nasjonale teknologiplattforma for bioinformatikk.

[wip4: photo=723873 width=512 align=middle]

– Det gjeld å bygge system som let biologar og medisinarar dele data og gjere analysar med bakgrunn i den biologiske ekspertisen dei har. Det ligg nokre potensielle snubletrådar i store gen-sekvenseringsprosjekt dersom forskarane ikkje heilt har tenkt igjennom analysen på førehand. Det har hendt at folk har kome på døra hos oss med svære datasett og spurt «kva kan de få ut av dette?»

Feltbiologen er ikkje som før

Kjetill Jakobsen stadfestar at behovet for folk som kan både biologi og informatikk, er skrikande. For dessverre er det ikkje slik at ei gen-sekvenseringsmaskin kan lese heile DNA-et frå start til slutt, og fortelje deg kva resultatet tyder. DNA-et må brytast opp i småbitar for at det skal vere mogleg å sekvensere det, og bitane må puslast saman igjen etterpå. Reknestykka blir enorme, og det beste ein kan håpe på, er ei plausibel tilnærmingsløysing. Å lage gode oppskrifter for utrekningane er difor eit eige forskingsfelt.

– Til og med eg greier å hente fram bilete på datamaskina mi, eller sende eit vedlegg, eller lage ein lysbiletepresentasjon. Men desse superdatamaskinene som gjer utrekningane for oss, har ikkje noko Windows-grensesnitt. Språket deira er Unix. Du må kunne programmering for å få dei til å gjere det du vil, og det samsvarar ikkje med det tradisjonelle biletet av ein typisk biolog, seier han.

Den tradisjonelle, typiske biologen er anten «grøn» eller «kvit», ifølgje Jakobsen. Den grøne samlar prøver og observasjonar i felten. Den kvite går med labfrakk og kan alt om mikroskop og laboratoriearbeid.

– No må begge dei to typane også kunne rekne, lage modellar og gjere statistiske analysar, og det er noko eg meiner utdanninga ikkje har teke inn over seg før heilt i det siste. Eg merkar at mange av studentane på grunnkursa ikkje er førebudde på det som ventar dei.

Fire års levetid

Datasetta frå sekvenseringsmaskina Jakobsen nyttar, blir lagra ved UiOs lagringsanlegg Astrastore, og utrekningane blir utført av tungrekneanlegget, som heiter Abel etter matematikaren. Noreg har nasjonale einingar, eigd av Kunnskapsdepartementet, som stiller opp med lagringsplass og reknekapasitet for vitskaplege data frå alle fag. Fagspesifikk e-infrastruktur, som Elixir, samarbeider tett med denne nasjonale organisasjonen. Fysisk er ressursane plasserte ved dei største universiteta, der dei kontinuerleg blir utdaterte og må fornyast.

– Ei tungreknemaskin kostar fort 50 millionar kroner. Når du kjøper ei slik maskin, har du ei vedlikehaldsavtale med leverandøren, som for anna avansert forskingsutstyr. Tommelfingerregelen er at etter fire år er ikkje vedlikehaldet lenger forsvarleg samanlikna med å kjøpe ei ny maskin, fordi dei utviklar seg så raskt, seier Roar Skålin i Forskingsrådet.

I august 2011, som ikkje kjennest så veldig lenge sidan, sto namna til både Kjetill Jakobsen og Inge Jonassen, saman med 39 andre, på Nature-artikkelen som fortalde at heile arvestoffet til den atlantiske torsken no var sekvensert. Torskegena avslørte at torsken sitt immunsystem var ulikt alle andre dyr: Torsken manglar komponentane som vernar mot bakterielle infeksjonar og gjev immunologisk minne, og dermed er det ikkje opplagt korleis ein kan lage vaksinar til torsk.

– Sekvenseringa av torskegenomet vart gjennomført over nokre månader i 2009. Etterpå var over ti av forskarane i Oslo og Bergen sysselsette på fulltid i omkring eitt år med rein databehandling. Sekvenseringsmaskinene som vart brukte, og som kosta fem–seks millionar per stykk, er no utdaterte. Vi kjøpte nye for ikkje så lenge sidan, og etter tre månader måtte vi gjere den første store oppgraderinga, seier Jakobsen.

Lagring for ei uviss framtid

Frå årsskiftet skal dei nasjonale tungrekne- og datalagringstenestene få ny organisering og meir langsiktig finansiering, i tråd med at behova berre blir større og større.

– Det vi treng, er sikker lagring med eit langsiktig perspektiv. Difor får den nye organisasjonen eit større strategisk ansvar for utviklinga framover, seier Skålin.

For det å skaffe tilstrekkeleg lagringsplass er berre byrjinga. I ei ideell verd skal datasetta kunne hentast fram om mange år og framleis vere leselege og forståelege, og dei skal kunne delast mellom forskarar som har ulike fagtradisjonar og forskjellig måte å snakke om tinga på.

[wip4: photo=723869 width=512 align=middle]

– Om ein skal kunne hente ut det potensialet som ligg i å kople datasett frå til dømes ei gruppe som forskar på immunsystem, og ei som forskar på kreft, avheng av korleis forskarane har merkt datasetta sine. Så det er store prosjekt som går ut på å utvikle standardar og lære folk å bruke dei, fortel Inge Jonassen.

– Og på toppen må du vite kva du må fortelje om eksperimentet ditt for at andre skal ha nytte av datasetta. Det seier seg sjølv at å lage gode system på alle desse nivåa, er for mykje å handtere for eitt land åleine.

Dele eller ikkje?

Open publisering av data er blitt den nye gullstandarden, men på den andre sida kan ikkje alle data delast med alle. Data som kan koplast til identifiserlege personar, bør helst ikkje kome på avvegar. I takt med at høgteknologiske diagnostiseringverktøy produserer meir og meir data, må det byggast digitale murar rundt lagringsanlegga for å ta vare på dei. Den nasjonale infrastrukturen for forskingsdata tilbyr eigne tenester for slike sensitive data. I den samanhengen er det ikkje uvesentleg kvar det fysiske lagringsanlegget står.

– Der kjem du inn på dei verkeleg vanskelege tinga. I utgangspunktet har alle land sine eigne lover for handtering av sensitive opplysingar. På same tid vil vi gjerne utveksle forskingsdata internasjonalt, for det er det som driv forskinga framover. Difor er det ikkje nok å ha gode datasystem, det blir også lagt store ressursar ned i å klargjere jussen kring dette og å utvikle system som oppfyller krav i lovverk og reglar. Det er ikkje gitt at sensitive data kan sendast ut av landet, seier Skålin.

Inge Jonassen vonar at Elixir-samarbeidet, som no er på veg frå planleggingsfasen og over i utføringsfasen, kan munne ut i internasjonale løysingar for handtering av sensitive data. Han ser for seg ei utvikling i retning av fleire skytenester og felleseuropeiske data-arkiv.

– Den verkeleg stramme flaskehalsen trur eg er analysekompetanse. Å skaffe tilstrekkeleg med folk som forstår og kan bruke analyseverktøya og samtidig kan biologi eller medisin. Akkurat no er dei same folka involverte i altfor mange prosjekt fordi det ikkje er mange nok som har den nødvendige kombinasjonen av kompetanse, seier han.